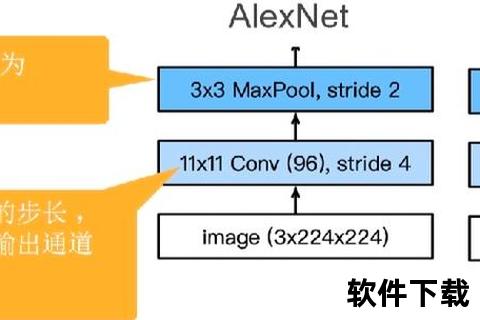

作为计算机视觉领域的基石数据集,ImageNet因其海量数据与精细标注成为算法研究的试金石。本文针对研究者普遍面临的下载流程复杂、标签处理困难等问题,系统梳理从账号注册、多途径下载、数据解压到标签映射的全流程操作,结合Python脚本与Shell命令提供可复现的解决方案。通过解析官方文件结构、验证集标签重组等核心难点,帮助开发者突破数据预处理瓶颈,高效开展深度学习模型训练。

获取ImageNet数据集的首选方式是通过官网(image-)注册教育邮箱账号,完成学术用途认证后下载ILSVRC2012子集。该子集包含138GB训练集(ILSVRC2012_img_train.tar)、6.3GB验证集(ILSVRC2012_img_val.tar)及开发工具包(ILSVRC2012_devkit_t12.tar.gz),需注意官网下载速度可能受网络环境影响。

针对国内用户访问受限的情况,可通过百度网盘获取预处理版本(提取码yzza),该资源包含已分包的训练集压缩文件和验证集标注文件。第三方镜像源如GitCode项目库提供完整数据集下载,支持多线程加速与断点续传,特别适合科研机构批量获取。

下载完成后,使用tar -xvf命令分别解压训练集与验证集至指定目录。训练集解压后将得到1000个类别子压缩包,需二次解压至对应文件夹:

mkdir train && tar xvf ILSVRC2012_img_train.tar -C ./train

cd train && for x in .tar; do mkdir "${x%.}" && tar -xvf $x -C "${x%.}"; done

验证集需配合开发工具包中的meta.mat和validation_ground_truth.txt文件,通过Python脚本建立类别映射。关键代码段包括使用scipy.io加载MATLAB元数据,根据文件名中的ID值匹配WordNet标识,最终生成与训练集一致的目录结构:

synset = io.loadmat('meta.mat')['synsets']

ground_truth = [int(line) for line in open('validation_ground_truth.txt')]

for filename in val_images:

val_id = int(filename.split('_')[-1].split('.')[0])

ILSVRC_ID = ground_truth[val_id-1]

WIND = synset[ILSVRC_ID-1][0][1][0]

shutil.move(filename, f"val/{WIND}/")

ImageNet采用WordNet层次化标注体系,每个synset对应三位字母数字编码(如n01440764)。开发工具包中的meta.mat文件存储synset编号与类别名称的映射关系,validation_ground_truth.txt则记录验证集图片的类别索引。研究者需特别注意:

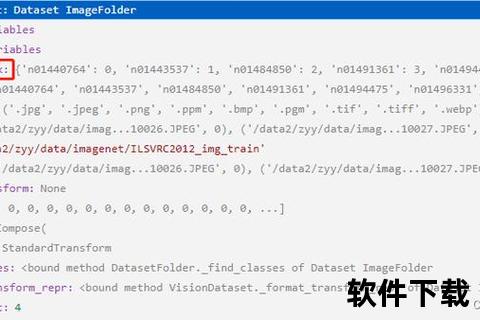

完成预处理后,使用torchvision.datasets.ImageFolder加载数据集:

from torchvision import datasets, transforms

train_transform = transforms.Compose([

transforms.RandomResizedCrop(224),

transforms.ToTensor

])

train_set = datasets.ImageFolder('train/', transform=train_transform)

val_set = datasets.ImageFolder('val/', transform=transforms.Resize(256))

建议配置DataLoader时设置pin_memory=True加速GPU传输,配合num_workers=4提升多进程加载效率。对于分布式训练场景,可使用DistributedSampler实现数据分片。

存储空间不足:原始数据集解压后约需300GB空间,建议使用EXT4/XFS文件系统避免FAT32的4GB单文件限制。可采用符号链接将不同子集挂载至多块硬盘。

验证集标签错位:当出现验证准确率异常波动时,检查脚本是否正确处理MATLAB索引从1开始的特性,并验证前100张图片的目录分布是否符合预期。

跨平台解压异常:Windows生成的Shell脚本在Linux执行时需运行dos2unix转换换行符,避免出现"^M"报错。对于嵌套压缩包,建议在Linux环境下使用pbzip2多线程解压。

通过本文的全流程解析,开发者可系统掌握ImageNet数据集的获取、处理与加载技术。建议结合具体研究任务,灵活调整数据增强策略与加载参数,充分发挥这一标杆数据集在计算机视觉研究中的核心价值。