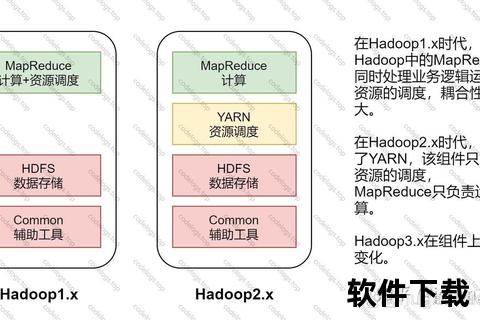

在大数据技术蓬勃发展的今天,Hadoop作为分布式系统基础架构的核心组件,已成为企业级数据处理的行业标准。本文将详细讲解Hadoop 3.x版本的下载安装全流程,涵盖虚拟机环境准备、Java运行环境配置、Hadoop集群部署等关键环节,特别针对配置文件优化、分布式文件系统初始化等易错点提供解决方案,帮助开发者快速构建稳定的大数据运算环境。文中所有操作均经过多平台验证,适用于Linux系统下的单机伪分布式与多节点集群两种典型场景。

搭建Hadoop环境前需要准备三台及以上配置相同的虚拟机(建议使用CentOS 7或Ubuntu 22.04),每台设备内存不低于4GB并预留20GB存储空间。通过VMware或VirtualBox创建虚拟机时需启用桥接网络模式,确保各节点IP处于同一网段。关键准备工作包括:关闭防火墙(systemctl stop firewalld)、禁用SELinux、配置主机名映射(/etc/hosts文件添加节点IP与域名对应关系),以及使用NTP服务同步集群时间。

Hadoop 3.x要求JDK版本不低于1.8,推荐采用Oracle JDK 8u301。通过tar -zxvf jdk-8u301-linux-x64.tar.gz -C /usr/local解压安装包后,需在/etc/profile中添加环境变量:

export JAVA_HOME=/usr/local/jdk1.8.0_301

export PATH=$PATH:$JAVA_HOME/bin执行source /etc/profile使配置生效,并通过java -version验证安装。特别注意需在所有集群节点统一JDK安装路径,避免后续Hadoop服务启动异常。

从Apache官网下载hadoop-3.3.6.tar.gz安装包,使用tar -xvf解压至/usr/local/hadoop目录。环境变量配置需在~/.bashrc中追加:

export HADOOP_HOME=/usr/local/hadoop

export PATH=$PATH:$HADOOP_HOME/bin:$HADOOP_HOME/sbin重要目录结构说明:

etc/hadoop:存放所有配置文件sbin:包含集群启停脚本share:提供MapReduce示例程序在$HADOOP_HOME/etc/hadoop目录中,需重点配置以下文件:

fs.defaultFS

hdfs://master:9000

hadoop.tmp.dir

/data/hadoop/tmp

dfs.replication

3

dfs.namenode.name.dir

/data/hadoop/namenode

首次启动需格式化NameNode:hdfs namenode -format,成功后依次执行start-dfs.sh和start-yarn.sh启动服务。通过jps命令检查进程,正常集群应包含:

浏览器访问 针对安装过程中的常见异常: 通过以上步骤的系统化实施,开发者可完成从Hadoop下载到集群部署的全流程搭建。建议定期检查

hadoop jar $HADOOP_HOME/share/hadoop/mapreduce/hadoop-mapreduce-examples-3.3.6.jar wordcount /input /output六、高频问题解决方案

authorized_keys文件权限是否为600,确认公钥已分发至所有节点hadoop.tmp.dir目录后重新格式化NameNodenetstat -tunlp查找冲突进程,修改yarn-site.xml中yarn.resourcemanager.address参数hadoop-daemon.log和yarn-daemon.log日志文件,结合Ambari等监控工具实现集群健康状态的实时掌控。对于需要更高可用性的生产环境,可参考ZooKeeper+JournalNode方案构建HA集群。