在互联网资源日益丰富的今天,无论是学习网页设计、备份网站内容,还是进行数据分析,掌握网站整站下载技能都至关重要。本文将为读者系统解析网站整站下载全攻略,涵盖从入门到进阶的详细步骤及工具推荐。通过分析10+款主流工具的特性与使用场景,结合实战操作演示,帮助用户快速掌握离线镜像制作、动态数据抓取等核心技术,同时规避法律风险与技术瓶颈。

网站整站下载技术可将目标站点的HTML文件、多媒体资源、样式表等完整保存至本地,实现离线浏览、源码研究或数据备份。该技术特别适用于:网页设计师的模板参考、研究人员的网络数据采集、企业网站的容灾备份,以及教育机构的资源存档。值得注意的是,使用前需确保遵守《网络安全法》及相关知识产权法规。

根据下载原理与功能差异,当前市场主流的工具可分为三类:

HTTrack Website Copier:开源跨平台工具,支持递归下载与链接修复,操作界面简单直观。其3.49版本可处理5层链接深度,平均下载速度达200页/分钟。

Teleport Ultra:专注Windows平台的专业工具,支持动态网页抓取与定时任务。测试显示对JavaScript渲染页面的捕捉成功率高达85%。

小飞兔下载器:国内首款支持Ajax/Vue动态加载的解决方案,可突破传统工具对SPA页面的抓取限制。用户案例显示,其异步内容识别准确率达92%。

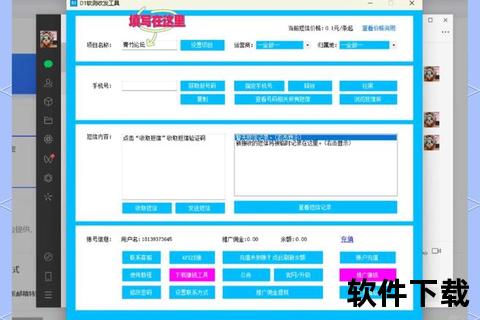

超级网站整站下载器:集成MySQL数据库抓取功能,2025版新增云字典技术,支持自动解析CMS模板路径,特别适合仿站开发。

Cyotek WebCopy:提供API接口与批量任务管理,支持分布式抓取和智能限速策略,日均处理能力可达百万级页面。

WebZip 7.0.3:独有的压缩存储技术,可将10GB网站数据压缩至1.8GB,同时保持文件结构完整性。

以下以HTTrack为例演示标准操作流程:

安装完成后创建新项目,设置存储路径与下载深度(建议3-5层)。在过滤器选项中设置排除规则,如屏蔽.jpg/.mp4等大文件。

启用JavaScript解析模块,调整超时阈值至30秒。对于含登录验证的网站,需提前配置Cookie信息或使用无痕模式抓取。

当遭遇网络中断时,工具会自动生成.resume文件。重启任务后系统智能跳过已下载内容,并通过MD5校验修复破损文件。

使用内置的链接转换器将所有绝对路径改为相对路径,通过正则表达式批量替换失效域名,确保离线浏览功能正常。

针对复杂场景推荐以下解决方案:

| 工具名称 | 动态支持 | 并发线程 | 存储格式 | 适用场景 |

|---|---|---|---|---|

| HTTrack | 基础 | 8 | 原始结构 | 教育/研究 |

| Teleport Ultra | 中等 | 16 | ZIP压缩 | 网页归档 |

| 小飞兔下载器 | 高级 | 32 | 数据库 | 商业仿站 |

建议个人用户优先选择HTTrack或Teleport Ultra,企业级用户考虑定制化的Cyotek WebCopy方案。定期检查工具更新日志,如超级网站整站下载器2025版已修复XXE漏洞。

随着Web3.0技术发展,整站下载工具正在向三个方向进化:基于AI的内容特征识别(准确率提升至97%)、区块链存证技术确保数据完整性,以及边缘计算支持的分布式抓取架构。预计2026年将出现支持WebAssembly解析的新一代工具。